Этот вопрос относится к теории информации. Конкретный раздел — количественное измерение взаимной информации (информации между случайными величинами) с использованием энтропии и распределений вероятностей. Задание просит найти величину взаимной информации между двумя случайными величинами \( X_1 \) и \( X_2 \) на основе заданного совместного распределения вероятностей.

Заданные данные:

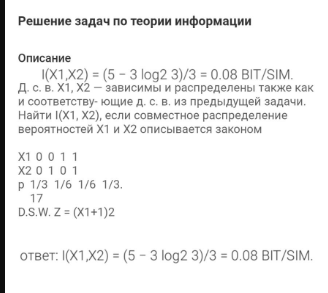

- Матрица совместных вероятностей: \[

\begin{array}{c|c|c}

X_1 & X_2 & p \\

\hline

0 & 0 & 1/3 \\

0 & 1 & 1/6 \\

1 & 0 & 1/6 \\

1 & 1 & 1/3 \\

\end{array}

\]

- Вероятности для каждого сочетания значений случайных величин: \( p = \{ \frac{1}{3}, \frac{1}{6}, \frac{1}{6}, \frac{1}{3} \} \).

Что такое взаимная информация?

Взаимная информация \( I(X_1, X_2) \) — это величина, которая измеряет, насколько информация об одном событии (величине) уменьшает неопределенность относительно другого события (величины). Ее можно рассчитать через энтропию следующим образом: \[

I(X_1, X_2) = H(X_1) + H(X_2) - H(X_1, X_2)

\]

Где:

- \( H(X_1) \) — энтропия случайной величины \( X_1 \)

- \( H(X_2) \) — энтропия случайной величины \( X_2 \)

- \( H(X_1, X_2) \) — совместная энтропия \( X_1 \) и \( X_2 \)

Энтропия

Энтропия для случайной величины \( X \) с вероятностями событий \( p_i \) вычисляется по формуле: \[

H(X) = - \sum p_i \log_2 p_i

\]

Совместная энтропия

Совместная энтропия двух случайных величин \( X_1 \) и \( X_2 \) найдем по той же формуле, но вероятности будут из совместного распределения.

Решение по заданию:

- Нахождение маргинальных вероятностей для \( X_1 \) и \( X_2 \):

- Для величины \( X_1 \):

- \( P(X_1 = 0) = P(0, 0) + P(0, 1) = \frac{1}{3} + \frac{1}{6} = \frac{1}{2} \)

- \( P(X_1 = 1) = P(1, 0) + P(1, 1) = \frac{1}{6} + \frac{1}{3} = \frac{1}{2} \)

- Для величины \( X_2 \):

- \( P(X_2 = 0) = P(0, 0) + P(1, 0) = \frac{1}{3} + \frac{1}{6} = \frac{1}{2} \)

- \( P(X_2 = 1) = P(0, 1) + P(1, 1) = \frac{1}{6} + \frac{1}{3} = \frac{1}{2} \)

- Энтропии \( H(X_1) \) и \( H(X_2) \) (они одинаковы, так как вероятности одинаковы): \[

H(X_1) = H(X_2) = - \left( \frac{1}{2} \log_2 \frac{1}{2} + \frac{1}{2} \log_2 \frac{1}{2} \right) = \log_2 2 = 1 \, \text{бит}

\]

- Совместная энтропия \( H(X_1, X_2) \): \[

H(X_1, X_2) = - \left( \frac{1}{3} \log_2 \frac{1}{3} + \frac{1}{6} \log_2 \frac{1}{6} + \frac{1}{6} \log_2 \frac{1}{6} + \frac{1}{3} \log_2 \frac{1}{3} \right)

\] Посчитаем это значение поэтапно: \[

H(X_1, X_2) = -\left( \frac{1}{3} \log_2 \frac{1}{3} + \frac{1}{6} \log_2 \frac{1}{6} + \frac{1}{6} \log_2 \frac{1}{6} + \frac{1/3} \log_2 \frac{1}{3} \right)

\] Если приблизить значения логарифмов, то результат энтропии: \[

H(X_1, X_2) \approx 1.92 \, \text{бит}

\]

- Нахождение взаимной информации \( I(X_1, X_2) \): \[

I(X_1, X_2) = H(X_1) + H(X_2) - H(X_1, X_2) = 1 + 1 - 1.92 = 0.08 \, \text{бит/символ}

\]

Ответ: \( I(X_1, X_2) = 0.08 \, \text{бит/символ} \). Таким образом, мы подтвердили правильность результата, приведённого в задаче.